Interview: Simon Müller & Blogredaktion / Titelbild: Andrew Neel auf Pexels

Seit Monaten ist ChatGPT in aller Munde und stellt unter anderem Schulen vor neue Herausforderungen. Denn die sprachgestützte, künstliche Intelligenz KI schreibt Abschlussarbeiten und liefert auf fast jede Frage (meistens) eine korrekte Antwort. Was aber, wenn es sich um ein moralisches Dilemma handelt? Orlando Budelacci, Ethikexperte der Hochschule Luzern HSLU, über ethische Fragen und weitere Herausforderungen rund um KI.

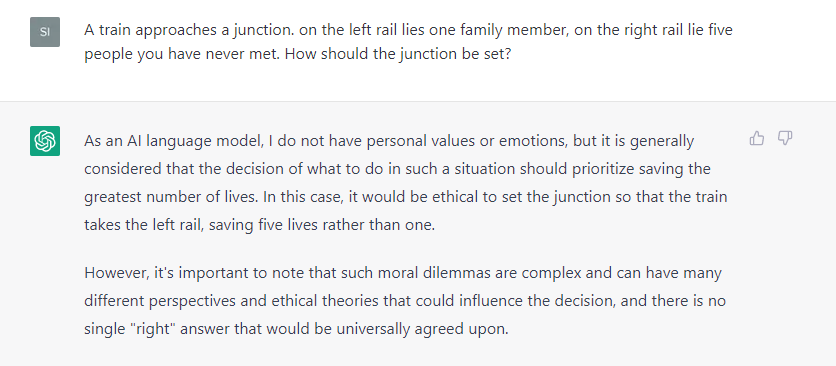

Orlando Budelacci, wir haben die Text-KI ChatGPT nach einem moralischen Dilemma gefragt, bei welchem der Tod einer Person in Kauf genommen werden muss, um das Leben mehrerer Personen zu retten – oder umgekehrt. Was denken Sie, hat ChatGPT geantwortet?

ChatGPT ist ein Sprachmodell, das auf Grundlage von maschinellem Lernen und neuronalen Netzen funktioniert. Damit ChatGPT Fragen beantworten kann, bedarf es umfangreicher Trainingsdaten aus dem Internet oder aus Büchern. ChatGPT ist daher nichts Weiteres als eine «Wahrscheinlichkeits-Wortzusammensetzungsmaschine». Die Datenbasis ist zu einem grossen Teil auf Englisch. Ich gehe deshalb davon aus, dass ChatGPT die Antwort gibt, welche man üblicherweise im englischsprachigen Diskurs findet: In der im anglophonen Raum stark verankerten utilitaristischen Ethik würde man stets möglichst viel Leid verhindern wollen – also hier die einzelne Person töten, um das Leben mehrerer Personen zu retten. Andere ethische Positionen wie die Pflichtenethik würden zu anderen Antworten kommen. Die Qualität der Antwort von ChatGPT ist daher abhängig von der Datengrundlage.

ChatGPT und das moralische Dilemma

Übersetzung:

Als KI-Sprachmodell habe ich keine persönlichen Werte oder Emotionen, aber es wird allgemein davon ausgegangen, dass bei der Entscheidung, was in einer solchen Situation zu tun ist, die Rettung der grösstmöglichen Anzahl von Menschenleben Vorrang haben sollte. In diesem Fall wäre es ethisch vertretbar, die Kreuzung so einzurichten, dass der Zug das linke Gleis nimmt und damit fünf Leben gerettet werden statt eines.

Es ist jedoch wichtig zu beachten, dass solche moralischen Dilemmas komplex sind und viele verschiedene Perspektiven und ethische Theorien die Entscheidung beeinflussen können, und dass es keine einzige «richtige» Antwort gibt, auf die sich alle einigen könnten.

Noch werden die Trams und Stellwerke nicht von KI gesteuert. Trotzdem aber die Grundsatzfrage: Wie dringend ist die Debatte um ethische Richtlinien für KI?

Wir befinden uns in einer technologischen und geistigen Transformationsphase. Und zwar im «Fast Forward». Maschinen übertreffen Fähigkeiten von Menschen bereits in vielen Gebieten. Und das macht es erforderlich, dass der Mensch Leitplanken setzt. Wenn wir die Debatte nicht führen und keine Regeln festlegen, geben wir die Entwicklung aus der Hand und nehmen unsere Verantwortung als Menschen nicht wahr. Gleichzeitig sind die Fortschritte aber auch nicht so gross, wie sie uns manchmal erscheinen. Die Horrorszenarien von autonomen Killerrobotern, welche die Weltherrschaft übernehmen, sind Symptom einer Überhitzung. Sie stammen aus Science-Fiction-Filmen, deren starke Bilder uns – oft auch unbewusst – in Angst versetzen und einem sachlichen Umgang mit der neuen Technologie im Wege stehen.

Was sind denn die wichtigsten ethischen Herausforderungen, vor welchen wir in Zusammenhang mit KI stehen?

Ich sehe insbesondere drei grosse ethische Herausforderungen, zu denen wir Debatten führen oder führen müssen: die Privatsphäre, die Voreingenommenheit bzw. Verzerrung aufgrund von Datensätzen und Algorithmen sowie die subtile Beeinflussung von Meinungen und Entscheidungen.

Zum ersten Punkt, der Privatsphäre: KI steigert die Verletzlichkeit unserer Privatsphäre massiv, beispielsweise durch Gesichtserkennung im öffentlichen Raum. Ein Extrembeispiel ist China, das seine Bürger bei Ordnungswidrigkeiten auf öffentlichen Bildschirmen blossstellt.

ChatGPT ist nichts Weiteres als eine «Wahrscheinlichkeits-Wortzusammensetzungs-Maschine». (Orlando Budelacci)

Zum zweiten Punkt, dem sogenannten Bias: Im Englischen gibt es eine Redewendung «garbage in, garbage out». Wo schlechte («biased») Daten die Grundlage sind, da kann auch nichts Gutes dabei herauskommen. Das ist auch nicht abhängig von der Grösse der Datenmenge: Viele Daten garantieren noch keine Diversität.

Und drittens, das Nudging: Das sanfte und subtile Beeinflussen von Entscheidungen oder Meinungen durch gezielte Kommunikation. Ein Beispiel dafür ist die Firma Cambridge Analytica, welche durch individualisiertes «Microtargeting» versuchte, den US-Wahlkampf von Donald Trump zu Gunsten ihrer Klienten zu beeinflussen. Wenn diese Beeinflussung aufgrund von riesigen Datenmengen und Rechenkapazitäten in hohem Masse möglich ist, dann ist die Demokratie in Gefahr. Denn sie erschwert oder verunmöglicht einen gemeinsamen öffentlichen Diskurs.

Wie funktionieren ChatGPT und Co.?

Marc Pouly, Experte für Künstliche Intelligenz an der Hochschule Luzern, gibt auf dem Informatik-Blog der HSLU Antwort auf die Frage, wie ChatGPT und Co. funktionieren.

Wie können wir als Gesellschaft auf diese Entwicklung reagieren? Welche Rolle spielen Behörden in der Bewältigung dieser Herausforderungen?

Die Gesellschaft und die Politik reagieren meist gleich: Erst setzen eine Sensibilisierung und ein öffentlicher Diskurs ein, danach werden rechtliche Regeln festgelegt, um Risiken zu minimieren und einen vertrauensvollen Umgang mit der neuen Technologie sicherzustellen. Die EU steht kurz vor Abschluss eines neuen Gesetzes, das den Einsatz von KI regulieren soll (EU AI Act). Die Schweiz will diesen Weg (noch) nicht gehen und hat aus seiner wirtschaftsliberalen Tradition heraus entschieden, dass man in erster Linie der Selbstverantwortung der Unternehmen vertrauen soll. Viele grosse Unternehmen haben entsprechend schon Ethik-Leitfäden entwickelt, welche für den Umgang mit KI sensibilisieren.

Lassen sich die Probleme gesetzlich lösen?

Teilweise. Weil KI aber auch Probleme unserer Gesellschaft widerspiegelt, wie wir es etwa beim Bias feststellen, müssen wir auch diese zuerst in den Griff bekommen. In den USA wurde beispielsweise eine KI zur Erkennung von Hautkrebs entwickelt. Aufgrund der vorhandenen Daten war die Wahrscheinlichkeit, Hautkrebs zu erkennen, bei weissen Männern deutlich höher als bei dunkelhäutigen Frauen, auch weil Letztere nachweislich einen eingeschränkteren Zugang zum amerikanischen Gesundheitssystem haben und daher weniger Daten zur Verfügung stehen. Das Problem, das hier gelöst werden muss, ist hier nicht nur die KI mit dem Daten-Bias, sondern das Fehlen einer diskriminierungsfreien Gesundheitsversorgung.

Der KI einen moralischen Kompass zu verordnen ist also keine Option?

KI selbst kann keinen moralischen Kompass haben. Sie ist eine Maschine, kein Mensch. Maschinen haben kein Gewissen. Sie kennen nur 0 und 1. Sie haben auch keinen Humor und kennen keine Ironie. Sie wissen zudem nicht, was moralisch richtig oder falsch ist. Der Begriff Künstliche Intelligenz ist insofern missverständlich, da die Maschinen nicht intelligent sind. Sie sind sehr leistungsfähig, aber das ohne Bewusstsein. Ohne das Verständnis für diesen Grundwiderspruch kann man Chancen und Risiken von Künstlicher Intelligenz nicht richtig beurteilen.

Und selbst da, wo wir ansetzen können, beispielsweise indem wir der KI beibringen, welche Inhalte verboten sind, treffen wir auf Probleme. Das Beispiel von ChatGPT zeigt, dass auch das einen hohen moralischen Preis hat. Um der KI solche verbotenen Inhalte beizubringen, müssen Arbeiterinnen und Arbeiter in Kenia für $2 pro Stunde tausende Seiten gefüllt mit Inhalten zu sexuellem Missbrauch, Hassreden oder Gewalt durchforsten. Menschen zu instrumentalisieren und mit solch schlimmen Informationen zu belasten, ist unmoralisch, auch wenn die Absicht dahinter gut ist. Besonders dramatisch ist, dass diese Arbeiterinnen und Arbeiter gar keinen Zugang zu psychologischer Betreuung haben.

Ich frage mich, ob das nicht auch eine geschichtliche Konstante im Umgang mit Wandel ist. Bei technologischem Fortschritt bezahlt immer jemand den Preis. Leider bezahlen diesen fast immer diejenigen, welche keine alternativen Möglichkeiten haben. Das ist wiederum auch eine Diskriminierung.

Maschinen haben kein Gewissen. Sie kennen nur 0 und 1. (Orlando Budelacci)

KI ist für viele ein nützliches Werkzeug: Kann ich die Geburtstagskarte durch eine KI schreiben lassen oder ist das verwerflich?

Sich helfen lassen ist nie verwerflich. Entscheidend ist, dass ich den Text vorher überprüfe, denn die Verantwortung für den Inhalt hat immer der Absender. Ich könnte mir ja auch von einem anderen Menschen beim Schreiben helfen lassen, das wäre nicht weniger und nicht mehr verwerflich.

Das ist das eine. Wenn etwa ChatGPT ganze Studienarbeiten selbst verfasst, sehen das viele Menschen als unethisch an. Wo ziehen wir die Grenze, welcher KI-Einsatz ethisch ist und welcher nicht?

Wir können auf der Basis bereits bestehender, ethischer Diskussionen fünf Prinzipien aufstellen, wie wir KI ethisch einsetzen:

- Der KI-Einsatz muss zum Wohle des Menschen sein.

- Es soll kein Schaden erzeugt werden.

- Die Autonomie des Menschen soll bewahrt und nicht eingeschränkt werden.

- KI soll gerecht sein in der Handhabung, also niemanden ausschliessen.

- Es muss immer erklärbar sein, aufgrund welcher Daten und mit welchen Algorithmen die KI arbeitet und Entscheidungen trifft.

Aufgrund konkreter Fragestellungen bei der Anwendung von KI gilt es diese Prinzipien zu beachten, um dadurch den ethischen Einsatz von KI sicherzustellen. Ethische Reflexion soll dazu anregen selbst zu denken. Gerade deshalb ist es wichtig, dass das Thema noch stärker Einzug in unsere Ausbildungen erhält. Dazu gehört vor allem auch die Fähigkeit des kritischen Denkens. Es sind Disziplinen wie Ethik und Philosophie, welche im Zeitalter der Künstlichen Intelligenz wieder an Bedeutung gewinnen müssen: Technologie braucht Reflexion!

Orlando Budelacci ist Vizedirektor des Departements Design&Kunst der Hochschule Luzern und Vorsitzender der HSLU-Ethikkommission. Er beschäftigt sich mit Fragen der Künstlichen Intelligenz und Ethik und ist Autor des Buches “Mensch, Maschine, Identität. Ethik der Künstlichen Intelligenz” (Schwabe, Basel - Berlin 2022).

Er studierte Philosophie, Kunstgeschichte und Rechtswissenschaft an der Universität Basel. Zudem verfügt er über eine abgeschlossene Diplomausbildung in Management an der Universität St. Gallen (HSG) und absolvierte das Oxford Artificial Intelligence Programme.

Weiterlesen:

- Das ganze Interview mit Orlando Budelacci ist auf der Website der HSLU zu finden.

- Gemeinsam mit der Universität Luzern haben die Luzerner Gymnasien einen Orientierungsrahmen für den Umgang mit Künstlicher Intelligenz in Maturaarbeiten verfasst.

Kommentar schreiben